Het doorvoeren van verbeteringen op het gebied van datakwaliteit, of zelfs alleen maar het meten ervan, kent vele aspecten, die tegelijkertijd moeten worden geadresseerd om succesvol te zijn. Daarnaast vergt het succesvol behandelen van dit onderwerp een bijzondere mentaliteit. Het gaat hier om het (durven) loslaten van perfectie en het inrichten van maatregelen. Maatregelen die werken volgens een vast principe: eerst compleetheid, dan volwassenheid. Deze insteek is voor sommige organisaties een behoorlijke verandering, die op een goede manier begeleid moet worden.

De auteurs gaan in dit artikel in op zowel de inhoudelijke kant van datakwaliteit alsook op de wijze waarop daaraan invulling is gegeven in een praktijkcasus.

Inleiding

Het belang van de kwaliteit van data behoeft weinig toelichting: in een dynamische omgeving wordt organisaties steeds sneller gevraagd om te reageren. Hiervoor is snel de juiste informatie nodig, informatie die uit de alsmaar groeiende hoeveelheden data gehaald moet worden. Deze groeiende hoeveelheden data bevinden zich in een toenemend complex IT-landschap: de integratie van IT-systemen neemt toe, systemen zowel binnen als over de organisatiegrenzen heen worden geïntegreerd en wisselen data uit. Daarbij wordt data door het management gezien als een belangrijke asset met veel potentieel. Hoe dit potentieel goed kan worden uitgenut en wat daarvoor nodig is, is vaak niet helder. Hoewel het belang van data onmiskenbaar is, krijgt dit onderwerp nog vaak te weinig aandacht als potentieel probleem.

Behalve op de kwaliteit van data wordt ook druk gelegd op betrouwbare verantwoording aan toezichthouders en de financiële markten. Hiermee ontstaat behoefte aan een aantoonbaar kwalitatief rapportageproces. Kwaliteit van data is een disciplineoverstijgend thema (informatiebeveiliging, management reporting, actuariële berekeningen, financiële verslaggeving) waarbij vanuit verschillende disciplines modellen of perspectieven beschikbaar zijn om de kwaliteit van data te verbeteren. Omdat een verzekeraar ons benaderde met de behoefte aan een integrale benadering van datakwaliteit is, in samenwerking met deze verzekeraar, een aanpak voor datamanagement opgesteld.

Onder de naam ‘Data Governance’ is daar een organisatiebrede aanpak ontwikkeld, die op gestructureerde wijze datakwaliteit borgt. Voor datakwaliteit bestaat, zoals we later zullen zien, geen absolute norm; het gaat vooral om het in controle zijn op de processen rondom het invoeren van data, het bewerken en interpreteren van data en het verslag geven over de data.

Wat is datakwaliteit?

In dit artikel gebruiken we steeds de term data. We bedoelen hiermee de Engelstalige variant van het woord; in het Nederlands lijkt ‘data’ namelijk veel enger, bijvoorbeeld beperkt tot de bits en bytes in een database, hoewel de dikke Van Dale het uitlegt als: ‘een verzameling van gegevens’. Wij doelen op de veel ruimere (Engelse) interpretatie van het woord, zodat we voor data ook ‘gegevens’ of ‘informatie’ kunnen lezen.

Een eerste gedachte over de kwaliteit van data kan zijn: ‘de data moet kloppen’. Wat wordt echter exact bedoeld met ‘kloppen’? Laten we eens kijken naar een definitie van datakwaliteit. Hiervoor bestaan verschillende invalshoeken waar een gemeenschappelijke deler in te zien is.

Richard Y. Wang, programmadirecteur van het Total Data Quality Program op MIT, geeft vier dimensies aan het begrip ‘data quality’ ([Wang95]): data moet benaderd kunnen worden (accessible), de gebruiker moet in staat zijn data te kunnen begrijpen (interpretable), de data moet bruikbaar zijn voor de besluitvorming door de gebruiker (useful) en de data moet geloofwaardig zijn (believable).

Solvency II herhaalt een driewoordige mantra als het gaat om datakwaliteit ([CP43], p. 7): ‘appropriate, complete and accurate’ en stelt de datakwaliteit in functie van de rapportages en berekeningen die ermee gedaan worden. Hoe hoger de datakwaliteit, hoe beter de uitkomsten van berekeningen en hoe betrouwbaarder het rapport.

Jack Olson, lid van de Data Management International (DAMA) organisatie, schrijft over datakwaliteit ([Olso03]): ‘Data heeft kwaliteit als het voldoet aan de vereisten voor het beoogde gebruik. Met andere woorden: datakwaliteit hangt net zoveel af van de data zelf, als van het beoogde doel van die data.’ Het artikel over Enterprise Data Management dat elders in deze Compact is opgenomen, geeft meer informatie over datakwaliteit.

De gemeenschappelijke deler binnen deze definities is: 1) kwaliteit van data is breder dan de feitelijke juistheid van data, en 2) voor datakwaliteit bestaat geen absolute norm. Dit laatste heeft vooral te maken met de pluriformiteit van data: in verschillende contexten kan dezelfde data ervaren worden als van zeer wisselende kwaliteit. Als voorbeeld nemen we een ander kwaliteitsaspect, ‘tijdigheid’. Een simpel adresgegeven voor een ambulancedienst is tijdig, als het bij aanvang van de spoedrit is doorgegeven. Hetzelfde adresgegeven is voor de huisarts tijdig, als het vóór het opstellen en versturen van de rekening wordt doorgegeven. Als we de tijdigheidsnorm van de huisarts op de ambulancedienst zouden toepassen, zullen de gevolgen mogelijk zeer ernstig zijn, ofwel: wat voor de huisarts tijdig is, is voor de ambulancedienst te laat. Wat voor de huisarts kwaliteitsdata is, is voor de ambulancedienst rommel. We kunnen dus stellen, dat datakwaliteit contextgevoelig is.

Het gevolg voor de opzet van datamanagement in organisaties is dan ook dat normen voor de feitelijke juistheid van data, enkel gesteld kunnen worden door de gebruiker van deze data. Hiermee kunnen we stellen dat een ‘corporate’ aanpak om kwaliteitsnormen vanuit groepsniveau op te leggen, bij voorbaat gedoemd is te mislukken.

Het belang van de kwaliteit van data is, parallel aan het gebruik van data, de afgelopen jaren toegenomen, en het einde is nog lang niet in zicht. Steeds meer mensen hebben in hun werk met steeds meer data te maken. Steeds meer mensen baseren hun beslissingen op steeds meer data, al dan niet in geconsolideerde vorm. Steeds meer bedrijven zijn datagebaseerd. Dat heeft mede te maken met het feit dat vrijwel alles binnen een bedrijf in een of andere gegevensverzameling is gestopt. Automatisering is het sleutelwoord en wie automatisering zegt, heeft heel lang heil gevonden in databases. Zo staat tegenwoordig het personeelsbestand in een database, de urenregistratie, de facturering, het grootboek. Deze gegevensverzamelingen zijn allemaal ondersteunend aan het productieproces en dit ongeacht of het bedrijf ook werkelijk een fysiek product produceert. Om nog maar te zwijgen over de data die (nog) niet altijd formeel in databases wordt bewaard en geordend, zoals e-mails, projectdocumentatie, contracten en correspondentie. Als er in deze gevallen al sprake is van een geordende opslag (een documentmanagementsysteem bijvoorbeeld), dan is over de kwaliteit hiervan vaak slechts lastig een uitspraak te doen.

Daarnaast zijn vooral bedrijven in de financiële sector in hun essentie dataverwerkende organisaties. Waar een fysiek product ontbreekt, is het product vaak te zien als data. Kwaliteit van data is hier dus direct de kwaliteit van het geleverde product. Een bank heeft geen enkele fysieke productiestraat die bankrekeningen produceert, of die overschrijvingen verwerkt. Al wat er gebeurt is het muteren van data.

Kijkend naar onze discussie over de definitie, kunnen we concluderend zeggen dat datakwaliteit dus belangrijk is, belangrijker is geworden (en wordt) en niet absoluut te meten is, maar contextgevoelig. Laten we eens kijken hoe dat bij een verzekeraar heeft uitgepakt en hoe daar datakwaliteit concreet, meetbaar en uitvoerbaar is gemaakt.

Het ‘Data Governance’-project bij een grote verzekeraar

Zoals elke Europese verzekeraar, is ook deze verzekeraar bezig om Solvency II (SII) te implementeren. Speciale aandacht bij de implementatie is vereist voor het zorg- en schadeverzekeraarsdeel. Ten opzichte van het binnen SII-kader opgenomen standaardmodel, zijn hier voor de Nederlandse situatie afwijkingen mogelijk, die toegevoegde waarde opleveren. Een en ander is in kader 1 toegelicht.

Kader 1. Standaardmodel versus intern model.

Een kleine contextcursus voor diegenen die niet ingevoerd zijn in Solvency II. SII behelst een set aan regels die ervoor moeten zorgen dat het geld dat in reserve staat bij een verzekeraar, voldoende is om aan de verplichtingen te kunnen voldoen. Hiervoor houdt Solvency II een sterk risicogebaseerd regime aan. Op basis van het ingeschatte risico volgt een ingeschatte schadelast en dus een ingeschatte hoeveelheid aan reserves.

Solvency II komt met een ‘gratis’ standaardmodel dat voor de gehele Europese markt geldt. Hiervoor is een inschatting gemaakt van de risico’s en dat uiteraard aan de voorzichtige kant; liever te veel reserveren dan te weinig. Liever mee verlegen, dan om verlegen.

Voor sommige verzekeraars is het werkelijk gelopen risico veel lager. Zouden zij het standaardmodel hanteren, dan houden zij dus ‘onnodig’ veel geld in reserve. Geld dat niet besteed of geïnvesteerd kan worden. Een simpel voorbeeld is het schaderisico bij autoverzekeringen. Het standaardmodel houdt rekening met de gehele Europese markt, dus ook met de schadegevoeligere landen rondom de Middellandse Zee en in Oost-Europa. De auteurs van dit artikel willen zich afzijdig houden van internationale profilering, maar het feit is dat de schadelast in die landen hoger ligt; mogelijk doordat men daar minder voorzichtig rijdt; de omstandigheden gevaarlijker zijn, of de algemene staat van onderhoud van het wagenpark lager is.

Een Nederlandse verzekeraar heeft dan baat bij het ingaan van het ‘interne model’-proces. Zij mag een eigen model bedenken, dat de specifieke omstandigheden voor die verzekeraar in acht neemt. Nadat de toezichthouder (in Nederland is dat De Nederlandsche Bank) het model heeft goedgekeurd, mag de verzekeraar dit model, in plaats van het standaardmodel, hanteren voor (een deel van) de verzekeringsactiviteiten. Het idee is dat het interne model een betere inschatting geeft van het risico (lees: lager) waardoor het bedrag dat in reserve te houden is (de Capital Requirement) ook lager uitvalt. En dus minder geld dat geoormerkt is als reservekapitaal, en dus meer geld beschikbaar voor andere initiatieven.

Welk model gehanteerd wordt, bepaalt dus vooral de kapitaalvereisten, maar vrijwel alle overige bepalingen uit Solvency II zijn voor beide varianten geldig: in het bijzonder willen we de vereisten voor rapporteren aanstippen. Integraal onderdeel voor alle rapportages binnen SII is:

- de kwaliteit van data is aantoonbaar;

- de kwaliteit van het proces dat leidt tot rapporten is aantoonbaar.

EIOPA, de European Insurance and Occupational Pensions Authority (www.eiopa.org), is belast met de taak om de Europese wetgeving voor te bereiden en vorm te geven. Het is een onafhankelijk adviesorgaan voor de Europese Commissie en het Europees Parlement, dat uiteindelijk de wetgeving vaststelt.

Voor Solvency II neemt dat de vorm aan van adviezen, conceptteksten en consultation papers. In deze stukken wordt ingegaan op de vereisten, bijvoorbeeld ten aanzien van datakwaliteit, binnen de Solvency II-context. Dit zijn lijvige documenten. We zullen in dit artikel volstaan met de samenvatting dat de teksten nog altijd geïnterpreteerd moeten worden (zie kader 2).

Kader 2. EIOPA over appropriateness van data ([CP43], p. 8).

3.8 Data is considered to be appropriate if it is suitable for the intended purpose (e.g. the valuation of technical provisions, setting of assumptions) and relevant to the portfolio of risks being analysed (i.e. directly relates to the underlying risk drivers).

3.9 In particular, to be appropriate for valuation purposes the data needs to be representative of the portfolio of liabilities being valued and suitable to be used for an estimation of future cash flows (consistent with a prospective view on the behaviour of the relevant risks).

Verzekeraars hebben dus een aardige hoeveelheid werk te verzetten. Welke interpretatie moet de verzekeraar aan deze teksten geven? Hoe zorgt de verzekeraar ervoor dat de onderliggende interpretaties met elkaar in overeenstemming zijn? Hoe maakt de verzekeraar vervolgens deze interpretaties meetbaar en aantoonbaar?

De toezichthouder vraagt de verzekeraar de bovenstaande vragen te beantwoorden en oordeelt dan of de betreffende vereiste afdoende is ingevuld. Verzin een list, Tom Poes!

Een zeslagenmodel

In samenwerking met deze verzekeraar heeft KPMG een model opgezet dat deze uitdagingen het hoofd moet bieden. Uitgangspunten van de gehanteerde aanpak zijn: 1) maak onderscheid tussen aspecten op groepsniveau (aangeduid als ‘Big G’) en aspecten per proces/afdeling/systeem (aangeduid als ‘little g’), en 2) het kan niet zo zijn dat er nog nooit op kwaliteit van data is geacteerd: dus: ‘wat ligt er al?’ in plaats van ‘waar zijn er tekorten?’.

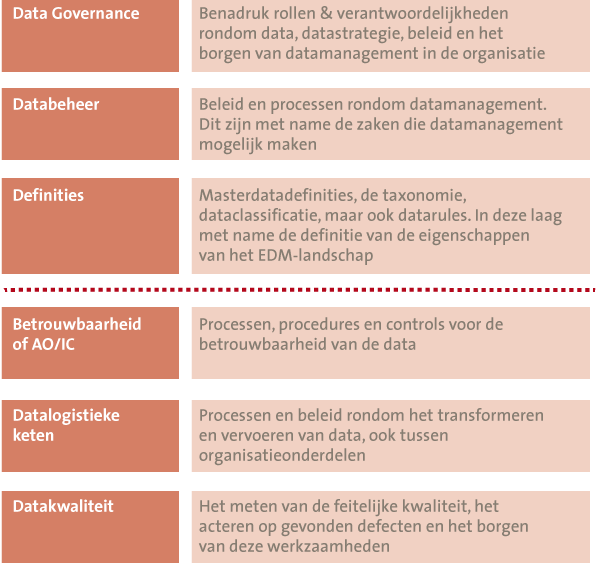

De taak die voorligt, lijkt erg groot. Analoog aan de vraag ‘Hoe eet je een olifant?’ is het antwoord bij deze taak hetzelfde: stukje bij beetje. Uiteindelijk is het geheel ondergebracht binnen een integrale aanpak met zes abstractielagen: governance, databeheer, definities, AO/IC, datalogistieke keten en datakwaliteit.

Deze lagen zijn ontstaan op basis van een analyse van diverse theoretische modellen ([DAMA], [DGI], [CP43]). Per laag zijn vervolgens maatregelen benoemd, 69 in totaal. Verder zijn kwaliteitscriteria opgesteld per maatregel en zijn voorbeelden en templates opgesteld.

Vanuit het projectteam is aansluiting gezocht bij diverse initiatieven (processen en projecten) om 1) te waarborgen dat alle noodzakelijke maatregelen invulling krijgen, 2) ervoor te zorgen dat geen dubbel werk wordt uitgevoerd, en 3) de opheffing van het project na te streven (datakwaliteit zou structureel in de lijn belegd moeten zijn, niet in een tijdelijk project).

Een cruciale stap binnen dit proces is het besef dat datakwaliteit wel meetbaar is, maar niet absoluut meetbaar; er bestaat geen algemene meetlat voor de kwaliteit van data. Zeker niet in een organisatie waar veel verschillende mensen werken. Het valideren van data op basis van business rules (bijvoorbeeld ‘omzet > winst’, en ‘beginstand – afname + toename = eindstand’) geeft een aanzet, maar kan nooit volledig zijn.

Kader 3. TRUST, datakwaliteit en de datalogistieke keten.

Hoewel het begrip ‘trust’ niet gebruikt wordt in het raamwerk, is begrip van dit concept cruciaal voor het begrijpend uit kunnen rollen van het raamwerk.

Met ‘trust’ bedoelen we de ongrijpbare eigenschap die wij mensen automatisch aan elk stuk informatie koppelen en die we afmeten aan de persoon of instantie die dat stuk informatie uitzendt, of geeft. Deze trust heeft weinig te maken met de werkelijke kwaliteit van de data. Beursadvies van een straatkrantverkoper zal door veel mensen lager worden aangeslagen dan beursadvies van een analist bij een grote bank, hoewel dit in principe niets zegt over de werkelijke kwaliteit van de geboden informatie.

Trust zouden we kunnen waarderen met een rapportcijfer. We geven de straatkrantverkoper een 3 (hij gebruikt vreemd genoeg wel de juiste termen, wat hem geloofwaardiger maakt, maar we vragen ons af waarom hij nog straatkranten moet verkopen). De analist bij de bank geven we een 8 (deze grote bank stelt haar vertrouwen erin, dus de informatie zal zeker waarde hebben).

Als wij vervolgens hetzelfde stuk informatie weer doorspelen aan iemand anders, gaat er een nieuw trustgetal spelen, dat tussen ons en de andere persoon. De reis van de data wordt zo gekoppeld aan een reeks trustgetallen. Op deze reeks kunnen we allerlei principes loslaten: rekenkundig gemiddelde, zo sterk als de zwakste schakel, enzovoort.

Zonder de werkelijke kwaliteit van de data te kennen, kunnen we aan het eind van de rit toch iets zeggen over de datakwaliteit. Als er, zonder uitzondering, hoge trustgetallen geassocieerd zijn met de informatie, dan moet deze informatie wel goed zijn. Sterker nog: het feit dat er hoge trustgetallen zijn geassocieerd maakt de data als vanzelf van hoge kwaliteit: kennelijk voldoet deze dus aan de vereisten van het beoogde gebruik. Hoge trustgetallen impliceren namelijk dat veel mensen met de data hebben kunnen werken volgens hun eigen vereisten. En, zoals we gezien hebben, is dat nu één van de belangrijke componenten bij het bepalen van datakwaliteit!

Als we het logistieke proces van data verzamelen, bewerken en doorgeven voortaan ‘datalogistieke keten’ noemen, dan kunnen we stellen dat voor deze datalogistieke keten de datakwaliteit relatief hoog is. De datakwaliteit is in ieder geval hoger dan een keten met lagere trustgetallen. Een bedrijf zou dus moeten streven naar een zo hoog mogelijk trustgetal per stap in de datalogistieke keten.

Het zeslagenmodel richt zich niet zozeer op de data zelf, maar meer op de processen daaromheen. We bedoelen daarmee het proces van bewerkingen, verplaatsingen, interpretaties, transformaties en controles. Als de meetlat waartegen deze bewerkingen afgemeten worden, hoog ligt, dan moet dit uitstralen op de datakwaliteit. Met andere woorden: als de lat die bij elke stap over de data wordt gelegd hoog genoeg is en gegeven het feit dat de data het einde van de logistieke keten bereikt, moet dat logischerwijs betekenen dat er een zeker kwaliteitsniveau is gehaald.

Het zeslagenmodel hanteert het onderscheid tussen ‘Big G’ en ‘little g’. Gedachte hierachter is dat datakwaliteit op allerlei niveaus wordt beïnvloed. Het begint met een besluitvormingsstructuur en een proces om te komen tot een normstelling en prioritering. Deze activiteit vindt niet op het niveau van data zelf plaats, maar waarschijnlijk bedrijfsbreed en via hoger management: ‘Big G’ dus. Ook de veelgehoorde term eigenaarschap hoort hier thuis.

Aan de andere kant moet het uiteindelijk uitvoerbaar zijn voor werknemers die bezig zijn met data-entry of het bewerken van data; zij hebben meer en andere guidance nodig dan de EIOPA-teksten. Dat noemen we ‘little g’.

Een voorbeeld van een ‘Big G’-maatregel: het ontwikkelen van een ‘data dictionary’ waarmee voor relevante data een eenduidige definitie wordt opgezet, zodat helder is welke betekenis aan data gegeven moet worden. Een voorbeeld van een ‘little g’-maatregel: het afsluiten van een overeenkomst om de datalevering tussen applicatie X en applicatie Y te formaliseren. Hiermee wordt onder andere duidelijk wie welke data met welke frequentie dient te leveren en hoe dit proces wordt gecontroleerd. Door de regel op werkinstructieniveau te verwoorden, ontstaat een raamwerk dat naadloos kan worden geïntegreerd met het dagelijks werk. Sterker nog, daarmee wordt het onherkenbaar onderdeel van het dagelijks werk.

Laag voor laag

De integrale aanpak betekent dat alle facetten rondom datamanagement moeten worden geadresseerd. Door ze te verdelen in lagen, ontstaat een groepering die helpt bij het toewijzen van de maatregelen per laag (zie figuur 1).

Figuur 1. De zes lagen van datamanagement en de maatregelen per laag.

In de Data Governance-laag zitten vooral het besturingsmodel en de kaders waarbinnen geacteerd wordt. Deze laag is typisch bedoeld voor beleidsmakers en hoger management, die door hun sponsoring het belang binnen de organisatie kunnen benadrukken.

In de laag Databeheer bevinden zich de uitwerkingen van de strategie voor zover deze datamanagement raken.

In de laag Definities wordt vervolgens het speelveld gedefinieerd.

Deze eerste drie lagen zijn meestal geldig voor meerdere afdelingen, of meerdere organisatieonderdelen. Daarom worden ze samengevat met de term coördinatie, of, bij deze verzekeraar ‘Big G’. Het zijn de piketpalen waarbinnen datamanagement plaatsvindt.

De laag Betrouwbaarheid of AO/IC bevat toepasbare maatregelen en controls om de betrouwbaarheid van databewerkingen in processen te waarborgen. Hier vinden we KPI’s gericht op betrouwbare databewerking, maar ook werkinstructies en tooling.

In de laag Datalogistieke keten wordt het ambulante gedrag van data behandeld. Het geheel van verplaatsen en transformeren wordt hier de datalogistieke keten genoemd (zie ook kader 3). De maatregelen die moeten worden toegepast, zijn van een andere aard, doordat zij zich vooral richten op de beveiliging en integriteit van het transport en de bewerkingen.

In de laag Datakwaliteit, ten slotte, wordt op basis van de in de andere lagen vastgestelde normering, de feitelijke datakwaliteit gemeten, bewaakt en bijgesteld.

Deze laatste drie lagen zijn veel meer gericht op de uitvoering van het beleid en het toepassen ervan, vandaar dat zij worden samengevat met de term uitvoering of, bij deze verzekeraar, ‘little g’.

Waar in de bovenste drie lagen de uitvoering van de maatregelen vooral enkelvoudig is (per bedrijf, of bij een grote organisatie per bedrijfsonderdeel), geldt voor de onderste drie lagen dat de maatregelen net zo vaak moeten worden toegepast als er datalogistieke processen zijn: hun werking moet integraal worden aangetoond, dus kan er geen systeem, proces of transformatie onbeschouwd worden gelaten.

Zwakte van het model: een betonnen zwemvest?

We zijn ons bewust, dat door slechts nadruk te leggen op het proces geen garantie voor kwalitatieve output ontstaat. Als iemand namelijk onzinnige data invoert, welke vervolgens door een gehele keten met strenge controles loopt, dan eindigt de keten ook in onzinnige data (het welbekende voorbeeld van de productie van een betonnen zwemvest). Het volgende is daarbij op te merken:

- Als ‘onzinnige’ data het best haalbare is, bijvoorbeeld een verkoopplanning van een nieuw product in een nieuwe markt, dan is de informatie aan het einde wel degelijk van de hoogste kwaliteit, met de nuance: binnen deze context, voor het beoogd gebruik.

- Feitelijke kwaliteit van data is onderhevig aan maatregelen uit het raamwerk. Kennelijk vindt er dus geen ondubbelzinnige toepassing van het raamwerk plaats en dus is de totale integriteit ook niet te waarborgen. Het is van belang ook bij het opstellen van de planning en het doen van marktonderzoek, te handelen volgens de maatregelen uit het raamwerk.

Praktijkervaringen

Binnen het traject hebben we een aantal waardevolle ervaringen opgedaan, sommige in de vorm van geleerde lessen, andere in de vorm van randvoorwaarden. De praktijkervaringen zijn gecategoriseerd in drie belangrijke onderdelen van het toepassen van het model:

Onderdeel 1. Vaststellen van het raamwerk

- Begin met het formuleren van de eisen en wensen van datakwaliteit (top-down). Sommige zijn reeds bekend (wet- en regelgeving), sommige zijn aan verandering onderhevig (interpretatie van toezichthouder). De strategie van de organisatie is hierin ook van belang. Het braafste jongetje van de klas zal een ander eisenpakket hanteren dan de prijsvechtende nieuwe toetreder.

- Parallel aan de top-downinventarisatie is het nuttig om zorgvuldig te inventariseren welke maatregelen reeds aanwezig zijn (bottom-up). Het aanwezige wordt geïnventariseerd en aangesloten op de benodigde maatregelen. Zo ontstaat een kader dat relevant en specifiek is voor het bedrijf in kwestie.

- Combineer de eisen en wensen en aanwezige maatregelen tot ‘Big G’-maatregelen en ‘little g’-maatregelen. Geef van elke maatregel een heldere definitie (practice what you preach), zoek een subject matter expert en controleer de integriteit van het gehele model. Toets de bewoording van de maatregel op het juiste niveau. Spreekt de maatregel echt de taal van de functioneel beheerder?

- Maak de maatregelen zo tastbaar mogelijk en let hierbij op de verschillende niveaus binnen de organisatie. Wat de CFO aanspreekt is wat anders dan wat de manager van een operationele afdeling aanspreekt, of zelfs de medewerker die bijvoorbeeld grootboekboekingen verwerkt.

Onderdeel 2. Beheersing van het speelveld, compleetheid vóór volwassenheid

- Met het raamwerk kunnen vervolgens de datalogistieke ketens worden ‘behandeld’ om inzicht te krijgen in het speelveld. Daaruit zal blijken waar de blinde vlekken liggen en welke maatregel(en) ontbreken. Een belangrijke overweging hierbij is eerder genoemd: compleetheid voor volwassenheid. Daarmee werd bedoeld dat uiteindelijk beheersing belangrijker is dan de volwassenheid. Een integraal overzicht over de datalogistieke ketens is belangrijker dan weten dat op bepaalde punten in die keten er een hoge mate van volwassenheid is. De redenering daarachter is relatief eenvoudig en heeft te maken met ‘de zwakste schakel’. Zeer hoge kwaliteit in stap één zal teniet worden gedaan door zeer lage kwaliteit in stap twee, laat staan het volledig ontbreken van enig controlemechanisme in stap twee. In het laatste geval kan niet eens een uitspraak gedaan worden over de kwaliteit! ‘In control’ zijn betekent weten wat er goed gaat en vooral weten wat er niet goed gaat. Vandaar het belang van compleetheid. Door het gehele speelveld te overzien, krijg je ook inzicht in de blinde vlekken. Dit overzicht helpt bij het opstellen van een verbeterplan, eveneens integraal onderdeel van in control zijn.

- Heldere communicatie is nodig om het bredere perspectief van datamanagement te verduidelijken. Met name vanuit de technische hoek wordt datakwaliteit vaak verbonden aan ‘data lineage’: de technische perceptie om via een audit trail in IT-systemen zekerheid af te dwingen. Het gaat hier om de mentaliteit uit de inleiding. Het volgende is dan van belang bij het inzetten van het traject:

Onderdeel 3. Structurele inrichting van maatregelen

- Streef direct naar uitfasering van het projectteam. Het borgen van datakwaliteit is een lijnactiviteit en de verantwoordelijkheid dient daarom in de lijn te liggen. De verhoging van datakwaliteit komt voort uit handelingen in het dagelijks werk. Let hierop bij het overdragen van werkzaamheden naar de lijn en beoog een minimale impact op de dagelijkse gang van zaken.

- Het opstellen van verbeterplannen en het toezien op het uitvoeren daarvan kan het best aan de organisatie zelf overgelaten worden. Beschouw het projectteam daarbij als tijdelijke subject matter experts, die kunnen helpen en coachen bij het inzetten van het raamwerk.

- Om de inrichting van maatregelen een structureel karakter te geven kan het toepassen van de maatregel verplicht worden gesteld, of opgenomen worden in een verbeterplan voor de datalogistieke keten. Het uitvoeren en toezicht houden op de maatregelen kan door de reguliere (lijn)organisatie en (interne) auditor worden gedaan.

- Een gezamenlijk beeld van zwaktes in het zeslagenmodel is misschien wel belangrijker dan een initiële waardering van de datakwaliteit. Op basis van deze kennis kan namelijk direct begonnen worden met het opstellen van verbeterplannen, waarmee de verbeterslag wordt georganiseerd en de datakwaliteit zal verbeteren.

Literatuur

[CP43] CEIOPS’ Advice for Level 2 Implementing Measures on Solvency II: Technical Provisions – Article 86 f: Standards for Data Quality (voorheen bekend als Consultation Paper 43).

[DAMA] Data Management International, Standards, http://www.dama.org/i4a/pages/index.cfm?pageid=3495

[DGI] Data Governance Institute, Framework, http://www.datagovernance.com/fw_the_DGI_data_governance_framework.html

[Olso03] Data Quality, The Accuracy Dimension, 2003.

[Wang95] Toward Quality Data, an attribute-based approach, 1995.